揭秘苹果WWDC 2023 中的AI:深入探讨科技巨头的产品逻辑

今天,我们要深入探讨一个你可能最近听过很多次,但可能从未从这个角度看过的主题。我们要谈论的是苹果在2023年WWDC上发布的产品中的AI技术以及苹果独特的产品逻辑。

今天,我们要深入探讨一个你可能最近听过很多次,但可能从未从这个角度看过的主题。我们要谈论的是苹果在2023年WWDC上发布的产品中的AI技术以及苹果独特的产品逻辑。「不喜欢文字?请观看完整的YouTube视频」

苹果的AI技术和产品逻辑

我们不会在这里重复会议的演示幻灯片,而是要探索苹果产品的更深层含义。我们将看到苹果如何打造一个无缝的生态系统,每个产品和功能都紧密相连,最终在他们的最新产品Vision Pro中找到了合乎逻辑的结局。

与微软和谷歌的发布会不同,苹果在整个活动中并没有明确提到'AI'。这与谷歌等其他科技巨头频繁强调AI的做法形成了鲜明的对比。然而,苹果确实频繁提到了机器学习,这是AI领域的一项关键技术。所以,虽然'AI'这个词在会议中并未出现,但AI的精髓却无处不在。

首先,让我们从苹果的划时代的头戴设备,Vision Pro 开始。这款设备拥有三项关键技术,我们先简要回顾一下它的功能。

Vision Pro:AI与现实的完美融合

Vision Pro是一款混合现实(MR)眼镜。一旦你戴上它,你就可以看到你熟悉的应用出现在你的房间里,就在你的眼前。你的目光就是鼠标,看到哪里,点到哪里。只需轻轻移动手指,就可以选择和缩放。所有的应用界面就像是你周围空间中的真实物体,可以与你互动。

当有人走到你面前时,你们可以互相看到对方。这并不是因为Vision Pro有透明的镜片,而是因为它实时地将你的眼睛图像显示在眼镜外面的显示屏上,同时将外界的人和图像显示给你。正因为如此,虚拟与现实之间没有了界限,你可以沉浸在全景图像和三维视频中。

当你进行视频对话时,你会有一个非常真实的头像,可以动态反映你的面部和手势。这就是Vision Pro中最重要的一项技术,也是苹果最雄心勃勃的AI应用之一。由于你在视频通话时是戴着眼镜的,所以没有办法像电脑摄像头一样拍摄你的脸来当头像。因此,你的这个头像来自于使用Vision Pro前面的摄像头事先扫描你的面部后,创建的一个特殊的3D图像。而这里所用到的技术,就是机器学习。

苹果表示,这是使用最先进的机器学习技术创建的解决方案。在使用Vision Pro前部传感器进行扫描后,接着使用一个先进的编码器-解码器神经网络来创建你的数字Persona,也就是你的数字分身。虽然这里面没有提到AI,但是对比其他AI生成的数字人虚拟人,这才是我们想要的数字分身的效果。

Vision Pro的另一个革命性的技术,就是R1芯片。所谓混合现实,就是你所看到的内容是现实环境和数字内容的无缝叠加。这就意味着Vision Pro要以非常快的速度把周围环境,声音,你的动作,等等显示给你。如果处理速度不够快,比如你知道自己的头转向窗户了,但是窗户的图像过一会儿才显示出来,那么结果就是带着眼镜的人会很容易头晕。

做这些事情的,就是R1芯片。据苹果说,R1“处理来自12个摄像头、五个传感器和六个麦克风的输入”,在12毫秒内就完成了所有的处理动作。也许你对12毫秒没有概念,平均眨眼持续约100毫秒,这意味着R1芯片接收、处理输入并以比眨眼快八倍的速度传输新图像。

这种实时引擎,称之为革命性的技术绝对不夸张。你有没有想过还有哪一类产品会用到这样的技术呢?没错,就是汽车。自动驾驶的汽车,同样需要一个实时操作系统,来同时处理来自多个摄像头和传感器的数据,并且以极快的速度做出响应。所以说,如果苹果真的哪天造出了Apple Car,里面搭配了R1或者R1 Max芯片,那是一点都不会让人奇怪的。

这就是Apple的产品逻辑啊,就像我几年前买的iPad Pro,里面内置了LiDAR传感器,就是那个我花了钱但是几乎从来没有用过的激光传感器。这次Vision Pro一出来,我似乎明白了什么。LiDAR是Vision Pro的核心传感器之一,没有这个传感器,也就很难构造出Vision Pro的空间环境。

所以,Apple构建生态环境的能耐,真是让人不佩服都不行啊。

接下来Vision Pro第三项重要技术,这个倒是跟AI没关系了,就是它的 Micro OLED显示器。我有一台正在吃灰的SONY HMZ头显,也玩过几款VR眼镜,对头显的分辨率深有感触。头显就相当于你拿着放大镜在看一块小屏幕,所以要想得到清晰的画面,单眼至少要4K,注意两个指标,单眼和4K,我就碰到过有些眼镜号称4K,但是拿来一看是双眼4K。

Vision Pro呢,在宣传视频中苹果表示,在iPhone屏幕的一个像素大小的面积上,集成了64个像素。至于分辨率到底是多少,虽然没有官方准确的数据,但是根据Apple在两个显示器上的2300万像素的官方规格,Vision Pro中的每个Micro OLED显示器的像素密度为大约3400 PPI,每个显示器的分辨率为大约3800 x 3000,这确实是大于4K分辨率,3840*2160的,这是目前分辨率最高的头显。

关于Vision Pro,Twitter上有个很有趣的问题:

你怎么想?欢迎在评论区留言分享你的想法。

iPhone键盘:AI的实时应用

接下来我们要谈论的第二个重磅产品,就是具有增强的听写和自动更正功能的iPhone键盘。在WWDC 2023的iOS 17演示中,Apple软件工程高级副总裁在谈到新的听写和自动更正功能时,提到了机器学习和大家熟悉的Transformer语言模型。没错,Transformer就是用于ChatGPT的语言模型。

Transformer语言模型,不仅使自动更正比以前更加准确,同时由于Apple Silicon芯片的加持,可以在用户每次按键输入的时候运行这个模型。而且自动更正功能也适用于句子级别,也就是你在输入消息时可以给出完整句子的建议。并且它还能够了解用户的打字习惯,学习你的写作风格,然后给出相应地建议单词或短语。这不就是一个实时版的AI写作助手吗。

除此之外,听写功能也加入了“利用神经引擎的基于Transformer的语音识别模型”,用来提高准确性。

就这么一个小键盘,就涵盖了两大AI应用场景。写作助手和语音识别。

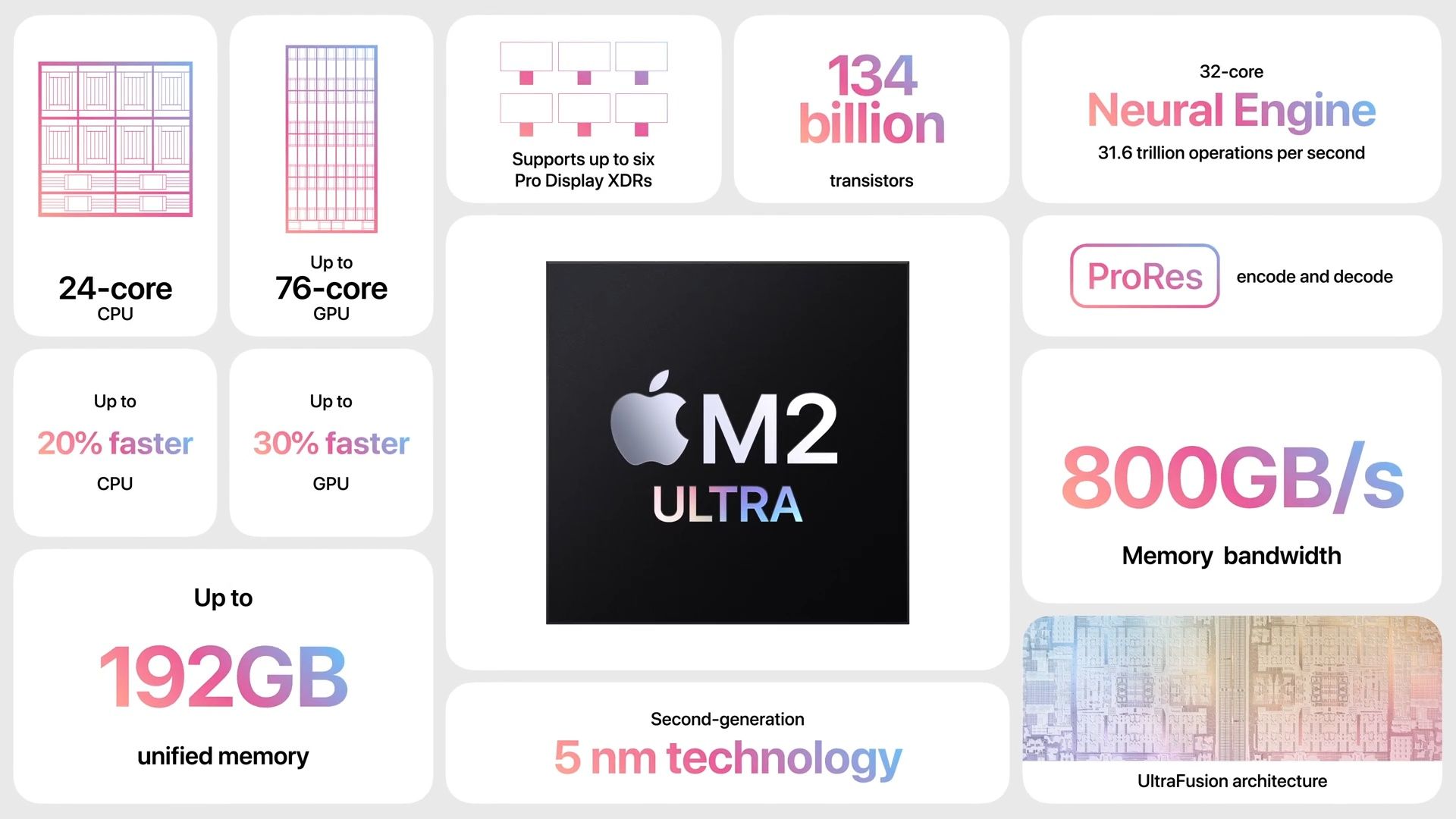

M2 Ultra芯片:AI的强大驱动力

第三个重磅产品,是M2 Ultra芯片。这是整个WWDC演讲当中,离AI最接近的一次描述。Apple表示,在单个系统中,它就可以训练大型的Transformer模型。M2 Ultra芯片具有24个CPU,76个GPU以及一个32核的神经引擎。更夸张的是,M2 Ultra支持192GB的内存。这也是M2 Ultra能够支持训练大型模型的关键,因为其他的甚至最强大的GPU也往往会因为内存不足而无法处理大型的Transformer模型。

因此,M2 Ultra芯片的发布让一些AI专家感到兴奋也就不足为奇了。

Apple在2017年的A11芯片中,就开始引入神经引擎了,这就是用来加速机器学习的,因此在苹果设备上,对AI进行即时处理要更加简单,比如我在M1的Mac Mini上,用Whisper来识别字幕,速度就要比Intel的Mac快很多。

苹果的AI生态系统

换句话说就是,在Apple的设备上,更容易集成AI功能并且具有更强的AI计算能力。这意味着什么呢?意味着苹果在边缘计算方面已经具有了很大意味着苹果在边缘计算方面已经具有了很大的优势,而边缘计算又有哪些用处呢?物联网、增强现实(AR)或者虚拟现实(VR)、自动驾驶汽车、AI等等,你能想到的未来前沿科技基本都在这里了。

所以你看啊,谷歌宣布了一系列语言模型,又是Bard又是Workspace的,微软呢,也一样又是Bing又是Copilot的,两家拼了命地往自己的生态系统里面塞AI,但是,就像我以前视频一直说的,苹果一直不发声,不知道在憋什么大招。WWDC看完,感觉就是,苹果这才是真正的生态系统呢。

虽然没提AI,但是处处都是AI,不断创新,把 AI 和机器学习技术集成到他们的各个产品中,你就可以在整个 Apple 生态系统中获得更加个性化、高效和愉快的体验。虽然没提元宇宙,但是我相信啊,一旦带上Vision Pro,一定会想到元宇宙这个词。

从手机到桌面,从耳朵到眼睛,Apple真的不是在打造绿洲吗?

感谢阅读!如果你喜欢这次分享的内容,请把我的这封周报分享给你的一个朋友。也欢迎你去我的YouTube频道 『 回到Axton 』看我的视频内容,咱们一起好奇地看世界!

保持健康,保持快乐!

Axton

Twitter | YouTube | Newsletter