今日主角:Mistral Large 模型以及如何尝鲜 | AI 快讯20240228

- 如何免费尝鲜 Mistral Large

- 微软与Mistral建立多年合作伙伴关系

- 我们是否都应该在大脑中植入芯片

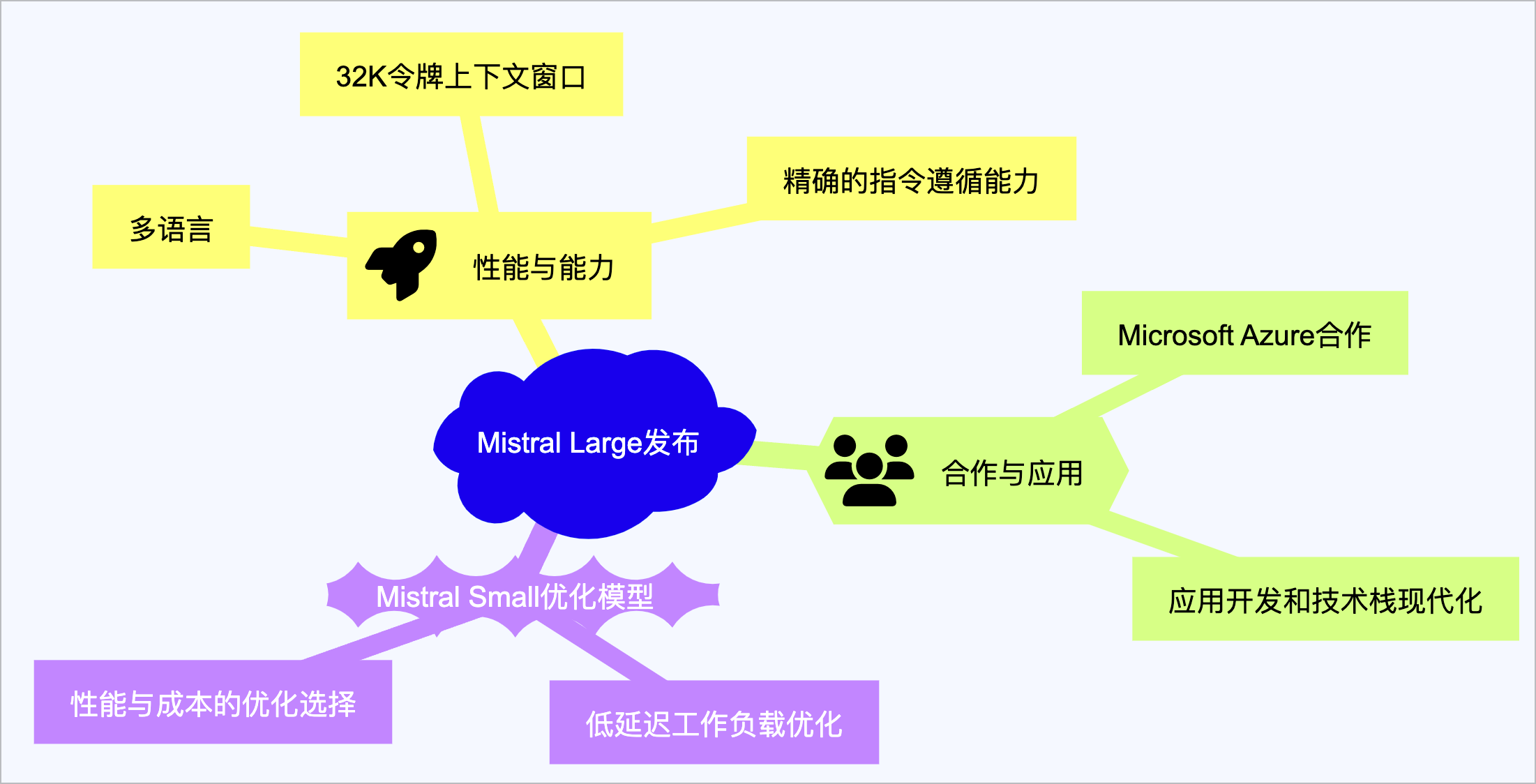

Mistral AI发布最新旗舰语言模型Mistral Large

原文链接:Mistral Large

Mistral AI最近发布了其最新且最先进的语言模型Mistral Large,这是一款具备顶尖推理能力的旗舰模型,通过la Plateforme提供,也是首个通过Azure分发的模型。

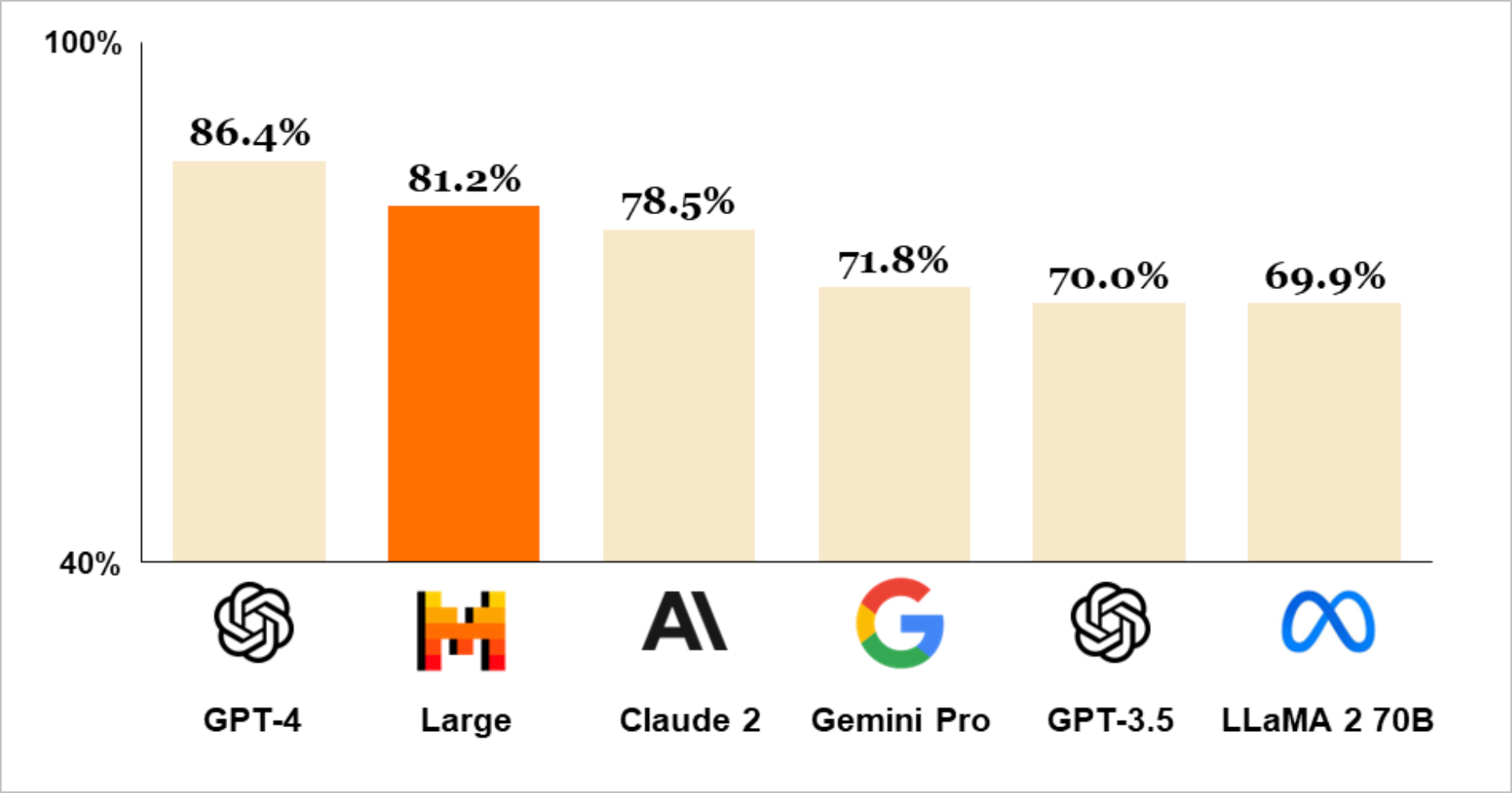

Mistral Large在多语言推理任务上展现出卓越性能,包括文本理解、转换和代码生成,使其成为继GPT-4后,通过API通用可用的世界第二大模型。该模型天生流利于英语、法语、西班牙语、德语和意大利语,能够精确回忆大型文档中的信息,且具备精确的指令遵循能力。

与Microsoft Azure的合作,进一步扩展了Mistral Large的应用范围,包括应用开发和技术栈现代化。此外,Mistral AI还推出了针对低延迟工作负载优化的Mistral Small模型,提供性能与成本的优化选择。Mistral Large的推出,为AI领域带来了新的可能性和应用前景。

如何免费尝鲜 Mistral Large

号称仅次于 GPT-4 的大模型,支持高级推理、函数调用、JSON 模式等,Mistral Large 一发布自然就吸引了众多的眼光,而且,Mistral AI 来自欧洲,它是一家法国人工智能初创公司,由来自Google的DeepMind和Meta Platforms Inc.的前研究人员创立。

虽然 Mistral AI 支持语言列表中没有中文,但是他实际上是认识中文的。如果想尝鲜 Mistral Large,有以下几种办法:

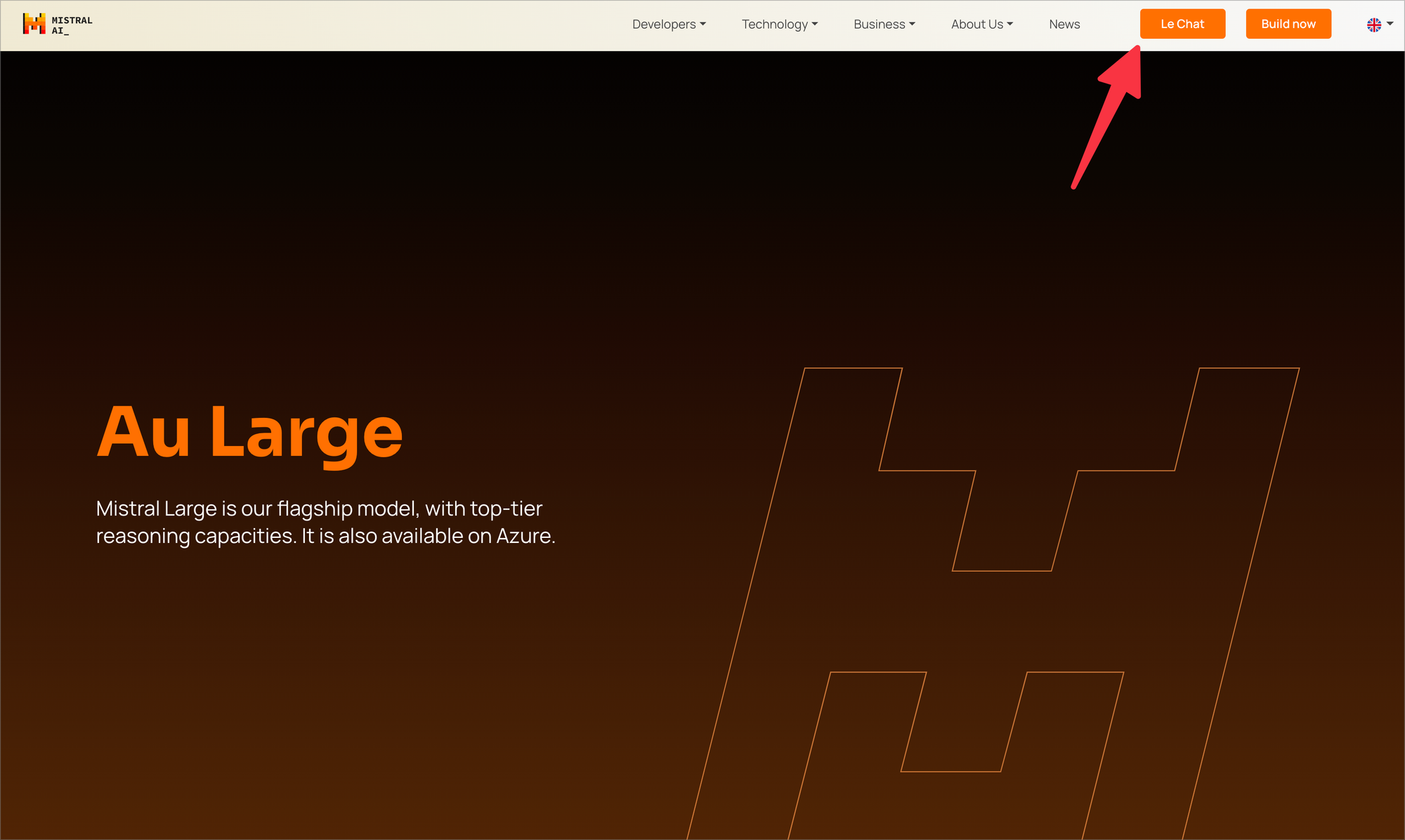

官网对话界面 LeChat

点击以上链接进入官网,点击右上角 LeChat 按钮或者直接通过网址 https://chat.mistral.ai/ 即可进入。虽然注册过程显示是加入等待列表,但是会很快。我昨天注册,今天再上来看就可以用了。

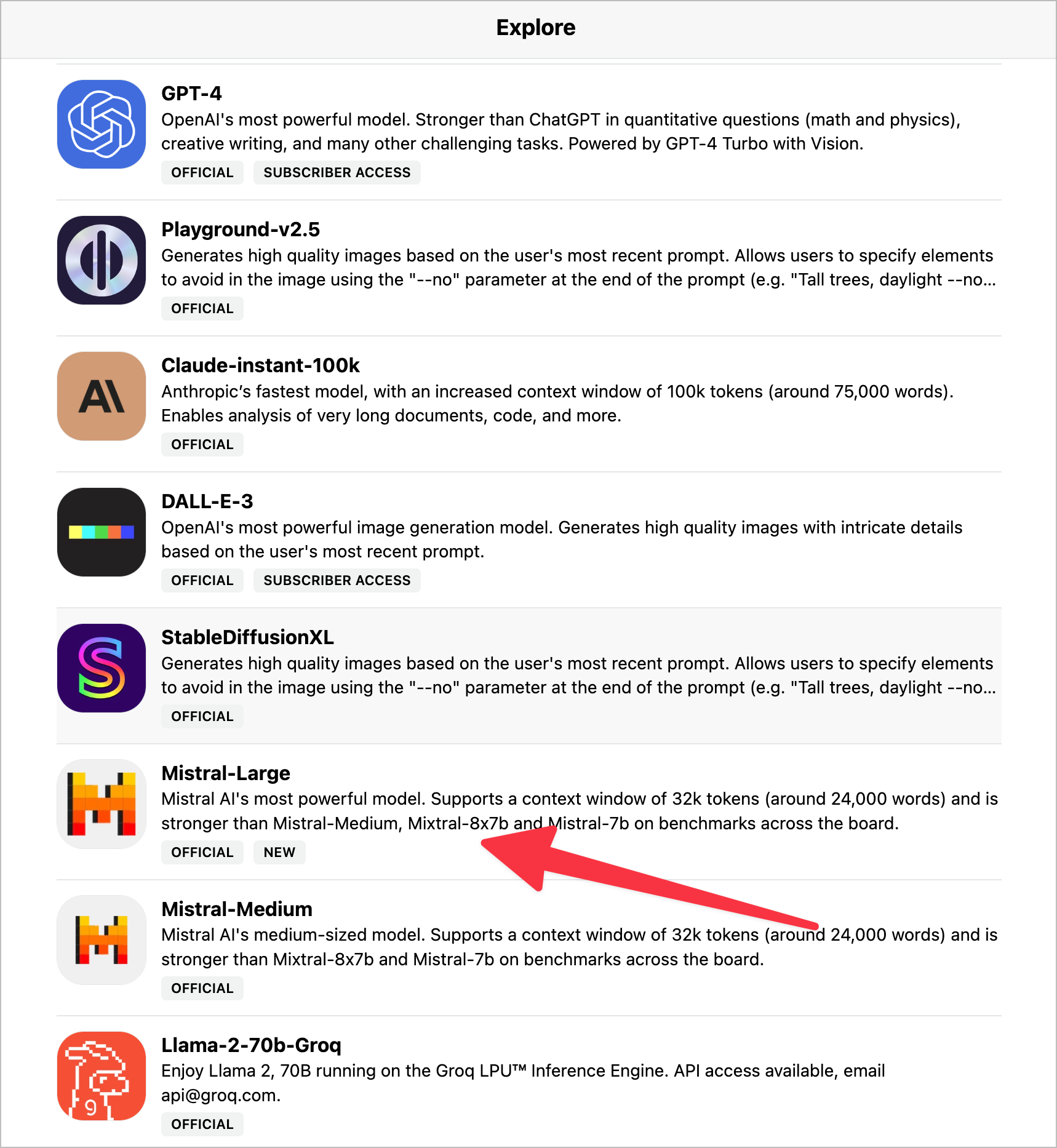

通过 Poe 使用

Poe 集成模型的动作向来都很快,进入之后在 Bot 列表中选择 Mistral-Large 就可以了。

本期「AI 快讯」由 Axton 与 AI 自动化 和 GPTs 共同协作完成。想要使用 AI 提升效率👇

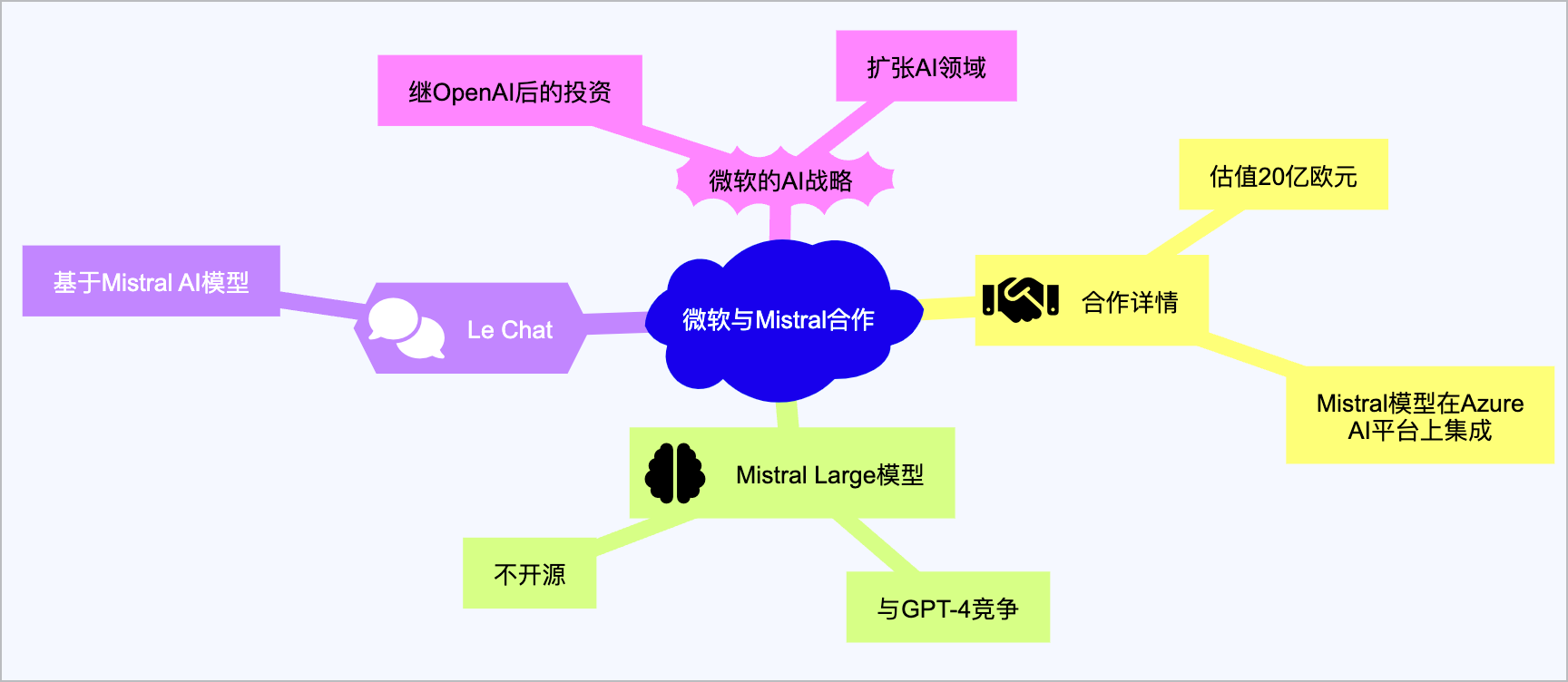

微软与Mistral建立多年合作伙伴关系

原文链接:Microsoft partners with Mistral in second AI deal beyond OpenAI

微软宣布与法国AI初创公司Mistral建立多年合作伙伴关系,Mistral估值达到20亿欧元(约21亿美元)。这标志着微软继与OpenAI的超过100亿美元投资后,再次在AI领域进行重大投资。合作将看到Mistral的开放和商业语言模型被集成到微软的Azure AI平台上,Mistral成为继OpenAI之后第二个在Azure上提供商业语言模型的公司。

Mistral发布了新的AI模型Mistral Large,旨在与OpenAI的GPT-4模型竞争,该模型将不会开源。此外,Mistral还推出了基于其AI模型的新聊天机器人Le Chat。与微软的合作为Mistral打开了探索更多商业机会的大门。尽管微软与OpenAI的合作中微软获得了非投票观察员席位,但在OpenAI的董事会中没有投票权。此次投资发生在OpenAI经历内部动荡几个月后,展示了微软在AI领域的持续投资和扩张策略。

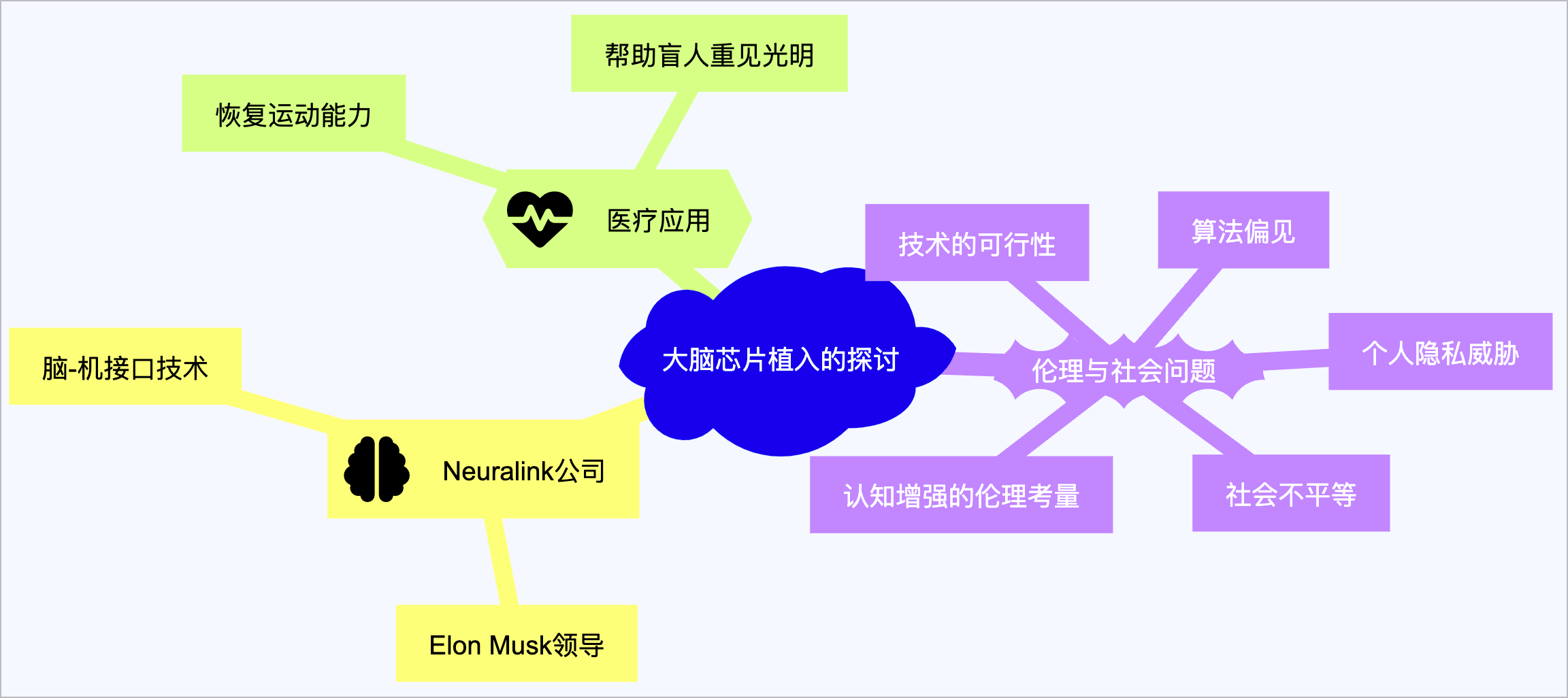

我们是否都应该在大脑中植入芯片?

原文链接:The big idea: should we all be putting chips in our brains?

Elon Musk的Neuralink公司引领了脑-机接口(BMI)技术的新纪元,该技术通过在大脑中植入探针,不仅可以监测大脑活动,还能通过电刺激改变思考、感受和行为。这项技术在医学上的应用前景广阔,例如为瘫痪患者恢复运动能力、帮助盲人重见光明等。

然而,随着技术发展,其在认知增强方面的应用引发了伦理和社会问题的深思,包括技术的可行性、可能加剧的社会不平等、算法偏见以及对个人隐私的威胁。文章强调,虽然BMI技术的医疗应用相对明确,但其在非医疗领域的应用需要谨慎考虑伦理和社会影响,特别是在追求科技进步时不应忽视这些潜在问题。

✨ 资源分享

好用GPTs

我的自用 GPTs 分享 → https://www.axtonliu.com/the-world-best-gpt-gpts/

好用工具推荐:

免费 Notion 账号 → https://affiliate.notion.so/axton

Notion AI → https://affiliate.notion.so/axtonliuai

超好用的自动化工具 Make → https://www.make.com/en/register?pc=axton

YouTube 频道必备工具:TubeBuddy → https://www.tubebuddy.com/axton

高性价比图片视频素材库:Envato → https://1.envato.market/axton

是的,以上是联盟链接,你通过这些连接注册或购买这些工具不会多花一分钱,但是我能得到一点微弱的好处,感谢对我创作的支持。

感谢阅读!如果你喜欢这次分享的内容,请点个👍(或者点个👎)让我知道,同时请分享给你的一个朋友。也欢迎你去我的YouTube频道 『 回到Axton 』看我的视频内容,咱们一起好奇地看世界!

保持健康,保持快乐!

Axton

Twitter | YouTube | Newsletter | AI精英学院